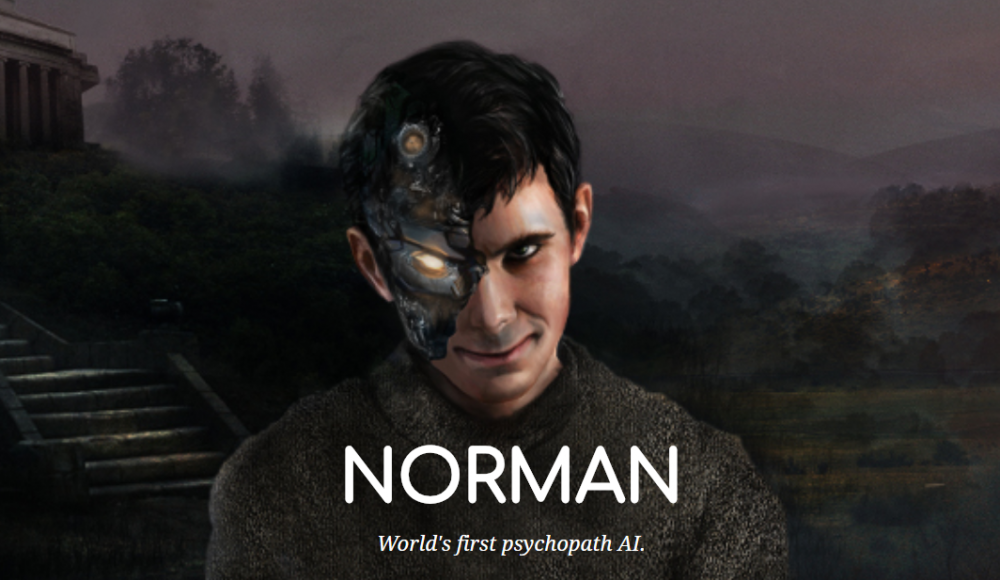

Штучний інтелект-психопат

Андрій Лозінський

Андрій Лозінський

1571

0

Norman - алгоритм, який навчений інтерпретувати фотографії та інші зображення. Але це не звичайний приклад штучного інтелекту (ШІ). Norman у всьому бачить жахи.

Звичайний алгоритм програми штучного інтелекту, відповідаючи на питання, що він бачить на зображенні, зазвичай інтерпретує його як щось суто позитивне.

Приклад: зграя птахів на гілці дерева. Norman, вивчаючи таке зображення, бачить людину, яку катують струмом.

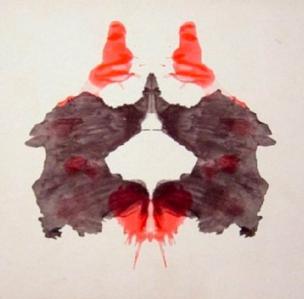

Цей психопатичний алгоритм створила команда дослідників Массачусетського технологічного інституту (MIT). Вони намагалися зрозуміти, як вплинуть на сприйняття світу штучним інтелектом фотографії та зображення з "темних куточків" інтернету. Програмі показували викладені у Reddit фотографії людей, що гинуть в жахливих обставинах. Потім алгоритму, який навчився розпізнавати зображення і описувати, що він бачить, показали тест Роршаха: симетричні щодо вертикальної осі чорнильні плями різних кольорів.

Norman постійно бачив жахи - трупи, кров і розруху в кожній такій плямі.

Той факт, що Norman бачить лише жахи, демонструє одну з фундаментальних проблем процесу машинного навчання, вважає професор Массачусетського технологічного інституту Іяд Рахвал.

"Набір вихідних даних важливіший за сам алгоритм, - говорить він. - Відбір інформації, яка застосовується для тренування штучного інтелекту, відбивається на тому, як цей штучний інтелект сприймає навколишній світ і які висновки він робить".

Norman бачить у всьому смерть, вбивства і розруху, тому що він не знає нічого іншого. Алгоритми штучного інтелекту, що вже застосовують у повсякденному житті, можуть бути упереджені. Залежно від того, на основі якої інформації їх тренували. У травні 2017 року, наприклад, опублікували результати дослідження, які показали, що алгоритм, який використовує один із судів у США для визначення ступеня ризику при звільненні затриманих під заставу, упереджено ставився до чорношкірих арештованих.

Але науковця Джоану Брайсон турбує можливість того, що хтось із програмістів вирішить навмисне вчити штучний інтелект чогось поганого. Щоб цьому запобігти, розробка штучного інтелекту повинна бути більш прозорою і дотримуватися певних правил.

Популярні новини

Популярні новини Зараз обговорюють

Зараз обговорюють